Der t-Tests gibt es ja viele, so dass gerne ein wenig Verwirrung aufkommt, wann man welchen verwendet.

Daher erhältst du in diesem Blog Post das rundum sorglos Paket zum Einstichproben-t-Test, auch t-Test für eine Stichprobe genannt.

Ich erzähle dir, worum es dabei geht, wann du ihn verwendest, wie er berechnet und interpretiert wird! Da kann dann t-Test-technisch nicht mehr allzu viel schiefgehen...

Und wenn du dazu und zu vielen bunten weiteren Tests Videos sehen möchtest, ist mein Videokurs zur Inferenzstatistik genau das Richtige für dich!

Allgemeines zum Thema t-Tests erfährst du hier.

Worum geht's beim Einstichproben-t-Test &

in welchen Bereich der Statistik gehört er?

WORUM ES GEHT

Um den Unterschied zwischen einem in der Population vermuteten oder bereits bekannten Mittelwert und dem Mittelwert einer neu erhobenen Stichprobe.

WOFÜR MAN IHN BRAUCHT

Vorwiegend für die Klausur, denn in der Praxis kommt dieser Test eher selten zum Einsatz...

Wie erwähnt, wird entweder ein bereits bekannter Mittelwert durch die Daten einer neuen Stichprobe herausgefordert oder aber es wird ein vermuteter Wert auf seinen „Wahrheitsgehalt" hin überprüft.

Der Einstichproben-t-Test (= t-Test für eine Stichprobe) ist eine der drei Varianten der t-Tests.

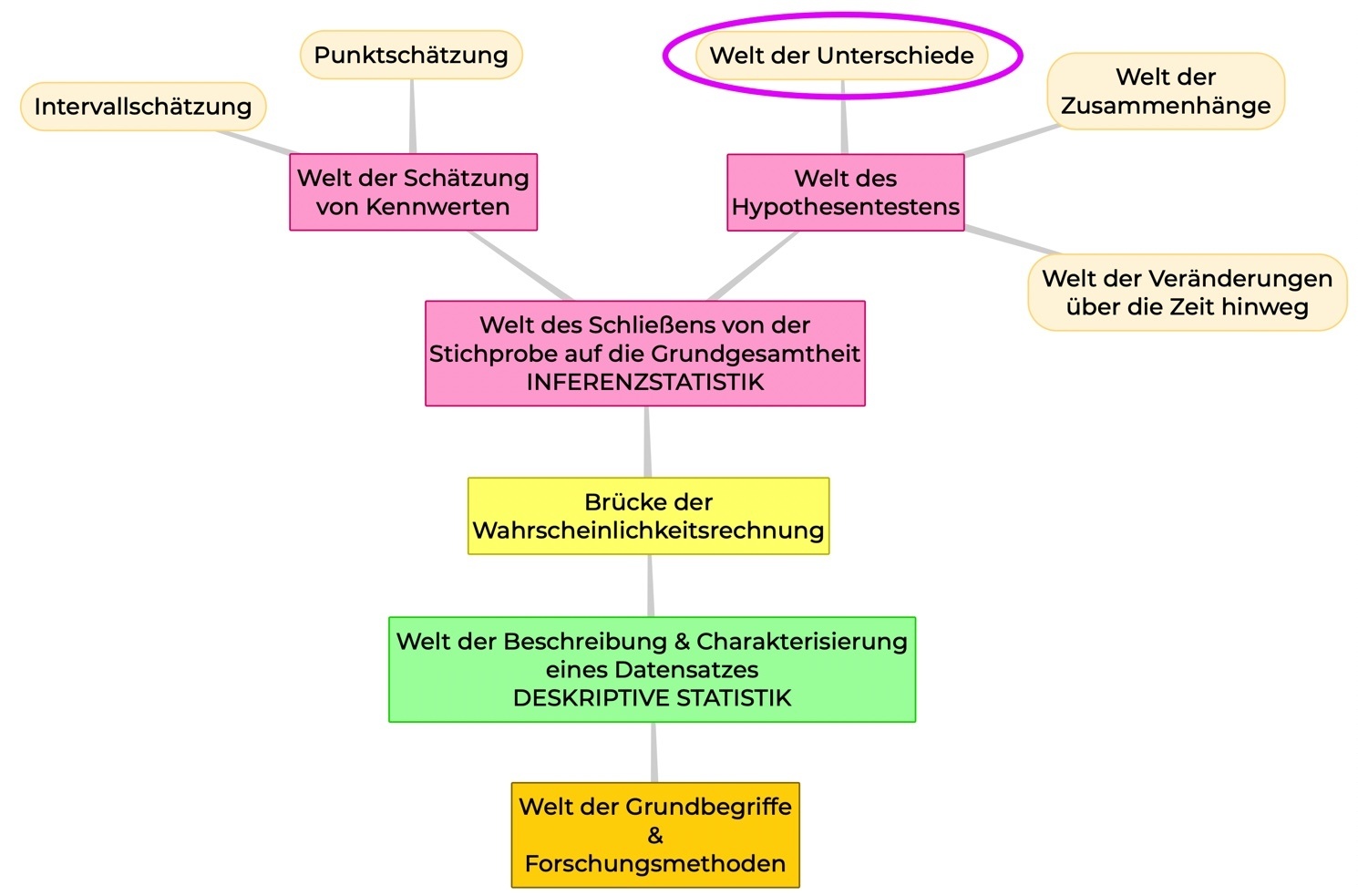

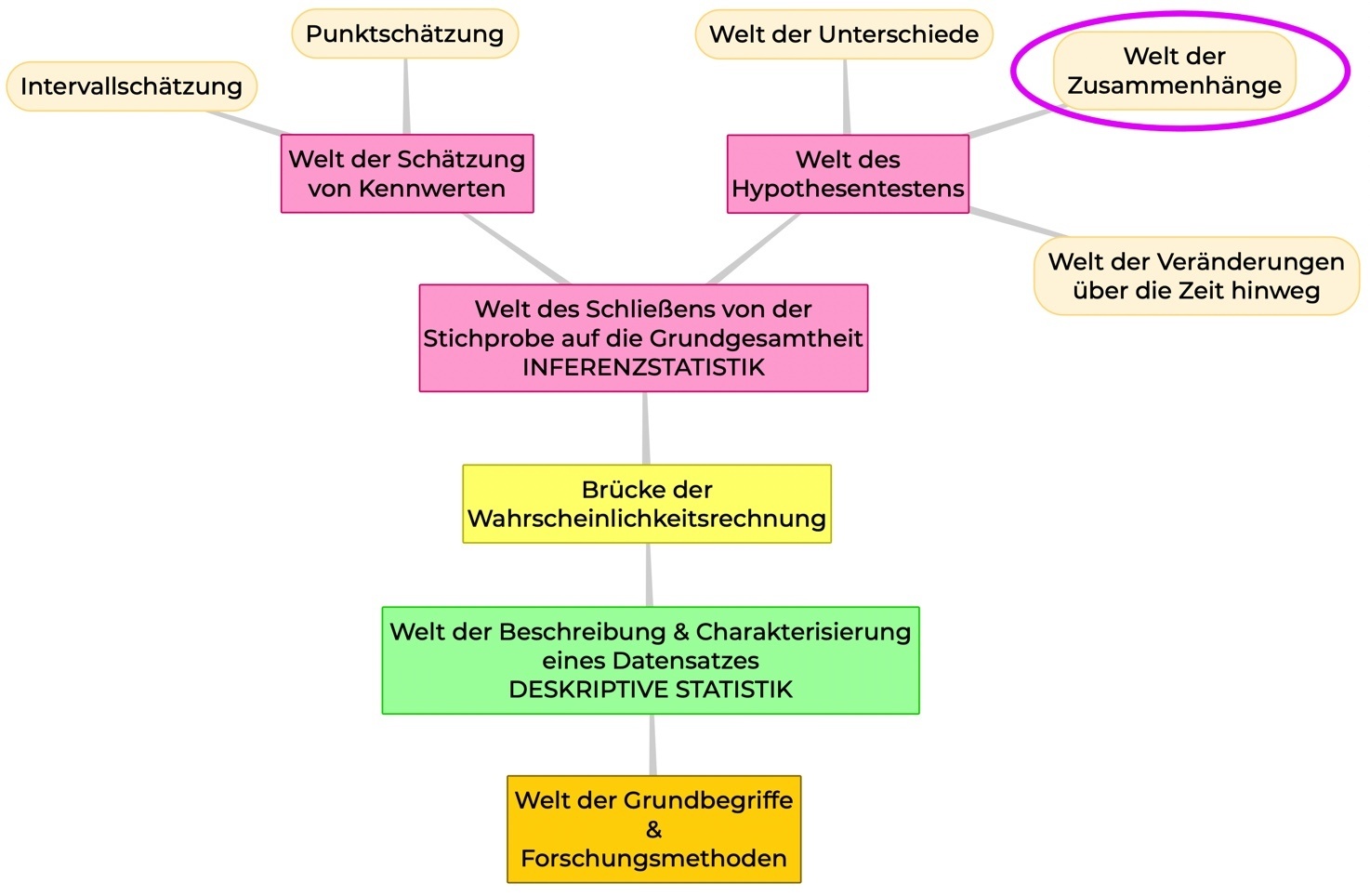

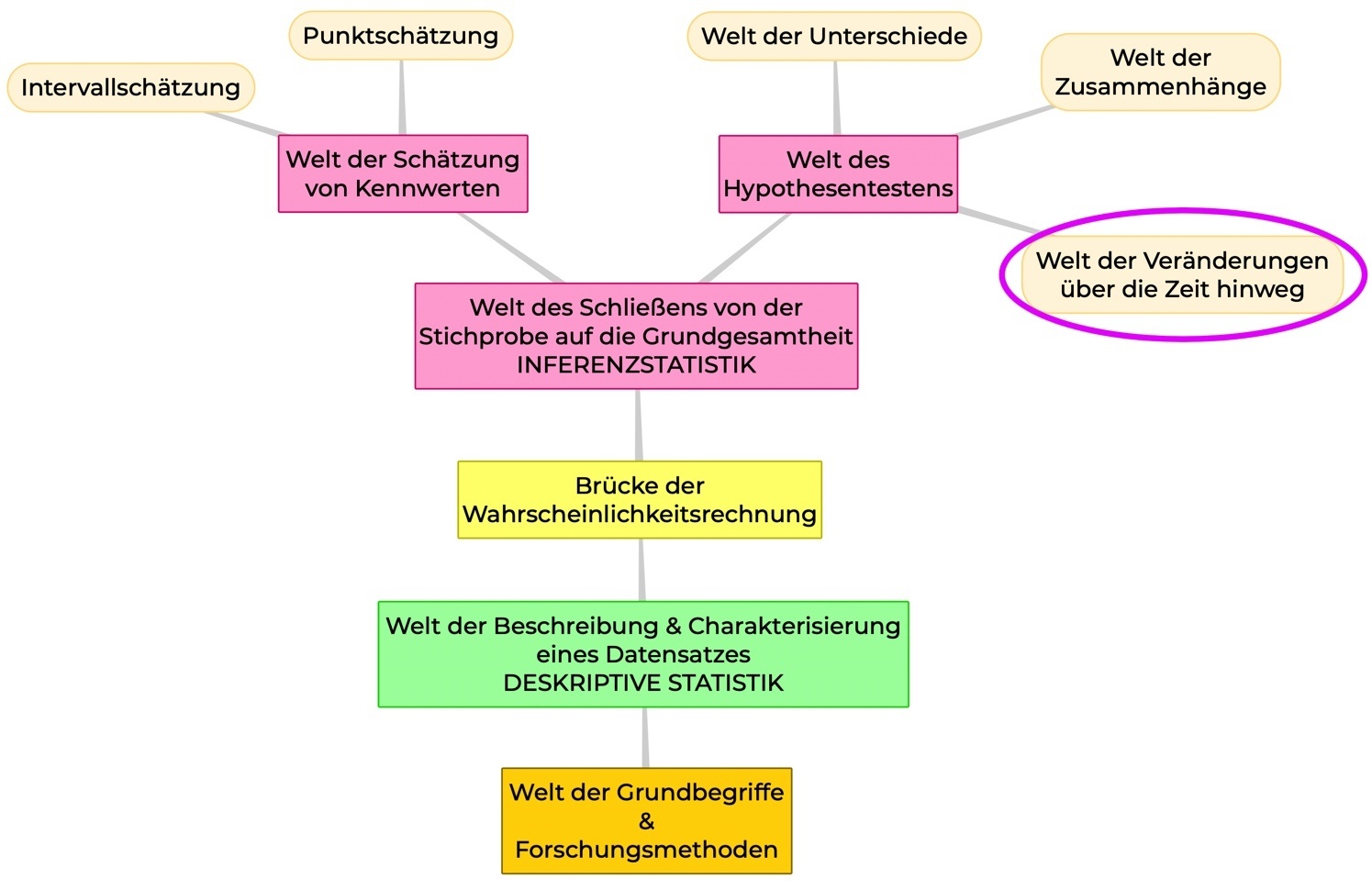

WO BEFINDEN WIR UNS?

In der Welt der Unterschiede, d. h. bei den Unterschiedshypothesen.

Beispiel

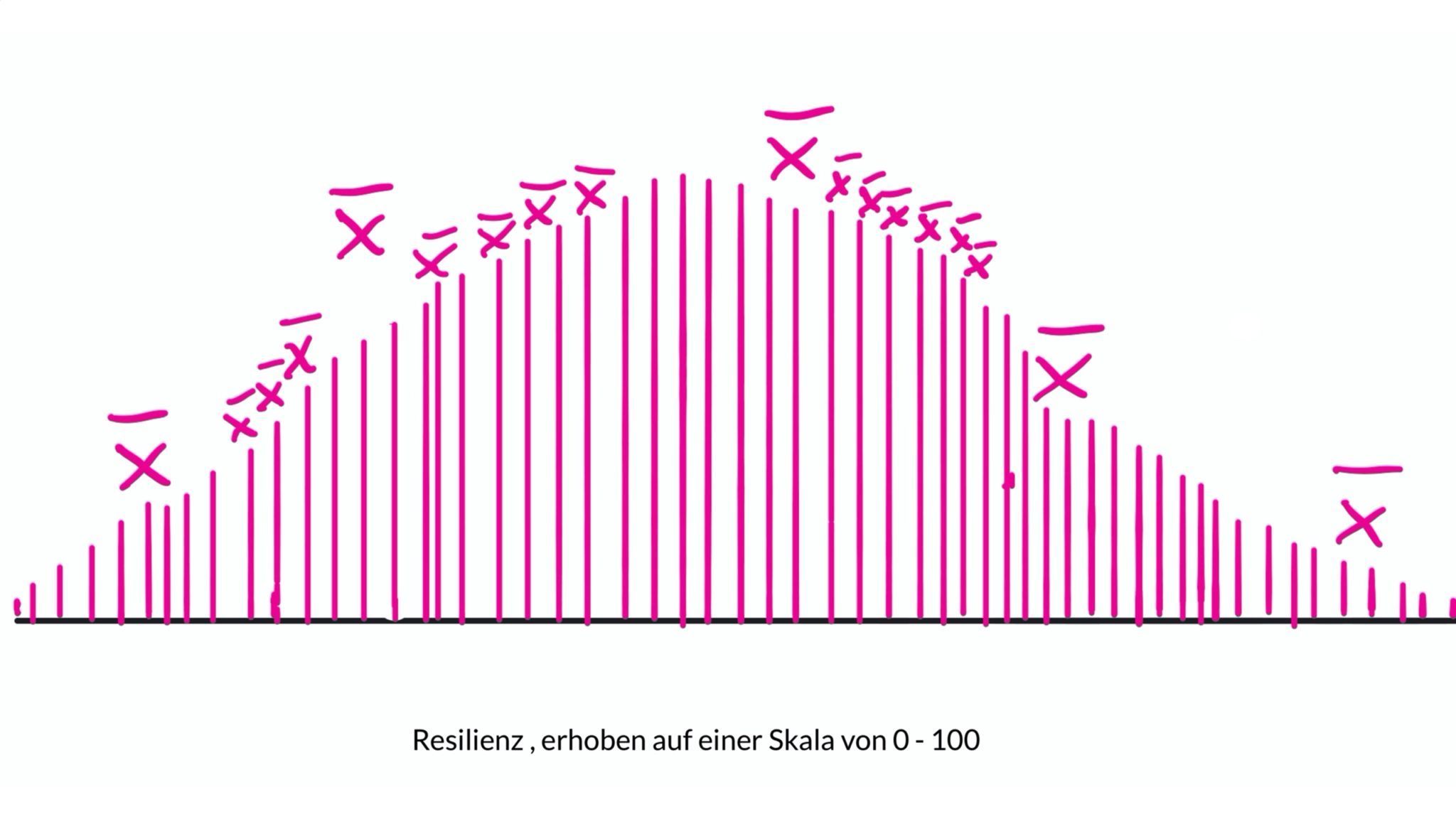

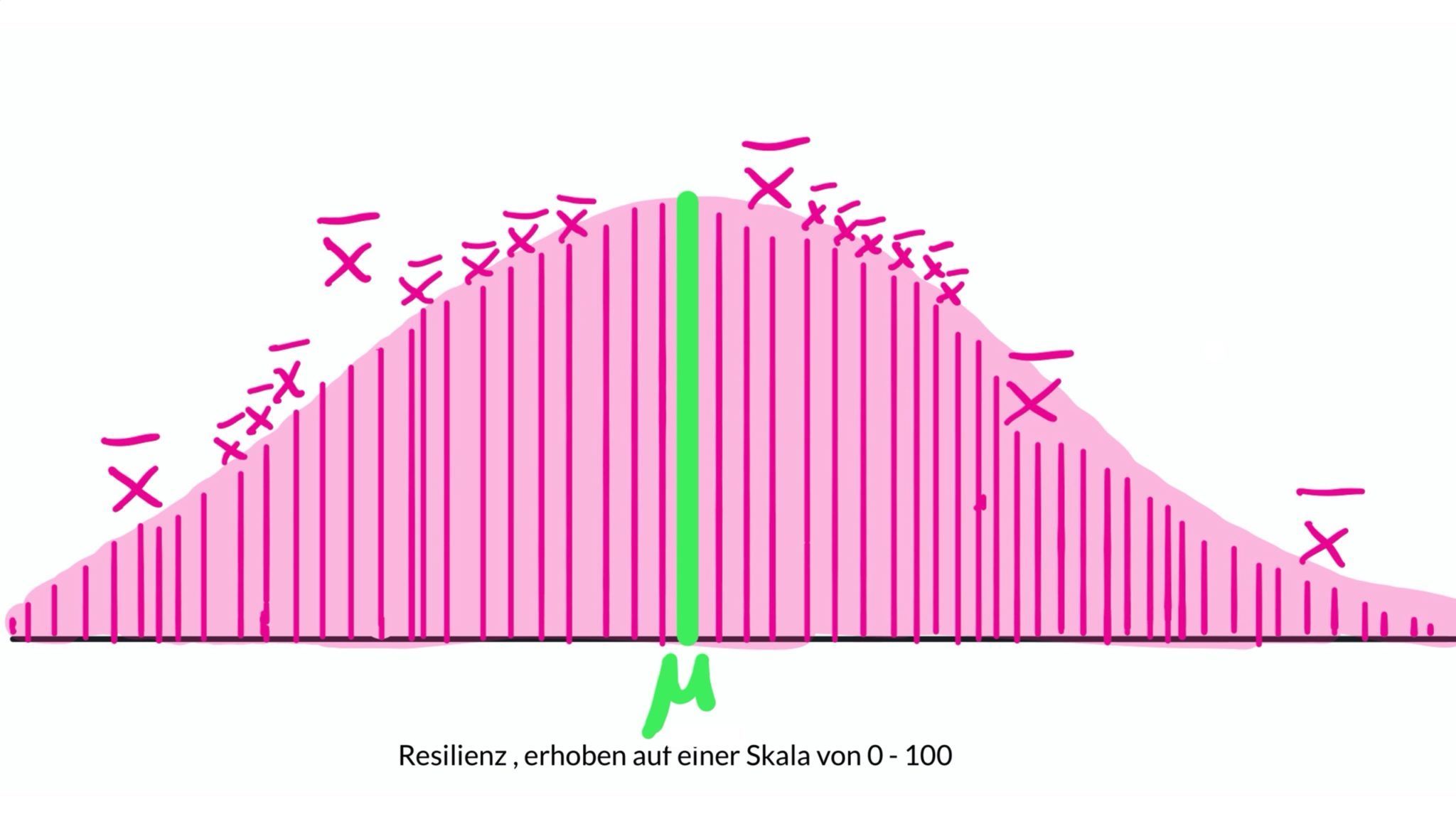

Du nimmst an, dass das durchschnittliche Glücksgefühl nach dem Urlaub (erhoben auf einer Skala von 0 – 100) signifikant von 50, dem „Mittelpunkt" der Skala, abweicht.

Nun schnappst du dir eine Stichprobe von 120 Reisenden und erhebst nach ihrer Rückkunft das Glücksgefühl.

Aus diesen 120 Werten berechnest du einen Mittelwert und vergleichst diesen mit deinem angenommenen Mittel- bzw. Erwartungswert von 50: Liegt er bei 50 oder weicht er deutlich ab?

Du stellst also den Mittelwert aus deiner Stichprobe einem hypothetisch angenommenen (oder auch bekannten) Mittelwert bzw. Erwartungswert mü gegenüber.

DAMIT HABEN WIR:

- einen Unterschied zwischen einem angenommenen und einem aus den Daten EINER Stichprobe errechneten Mittelwert

- voneinander unabhängige Messungen

- 1 metrische normalverteilte AV (= abhängige Variable)

- 1 Messung (= nur ein Messzeitpunkt)

= die klassischen Anzeichen für einen Einstichproben-t-Test!

Wie du zu dieser Entscheidung kommst, siehst du hier:

Wie du den Einstichproben-t-Test erkennst

Das könnten HINWEIS-WÖRTER sein wie:

- „Es ist bekannt, dass die durchschnittliche Aufmerksamkeitsspanne bei Erwachsenen 4 Sekunden beträgt. Eine Forscherin zweifelt diese Annahme an und will untersuchen, ob die Aufmerksamkeitsspanne tatsächlich deutlich höher ist."

- Es geht also darum, dass etwas bereits bekannt ist oder ein bestimmter Wert vermutet und dann anhand einer Stichprobe überprüft wird.

- Deine AV ist metrisch und die Varianz bzw. Standardabweichung unbekannt. Ist die Varianz bzw. Standardabweichung bekannt, solltest du stattdessen den Einstichproben-Gauß-Test (= z-Test) verwenden!

- Es werden nur bei EINER Stichprobe Daten erhoben

TYPISCHE FRAGESTELLUNGEN

In einem Gedächtnistest werden durchschnittlich 32 Wörter erinnert. 10 Jahre nach Erscheinen des Tests soll dieser Wert erneut überprüft werden, denn es wird angenommen, dass die Anzahl der erinnerten Wörter von 32 abweicht. (Ungerichtete Hypothese)

Es ist bekannt, dass die durchschnittliche Abenteuerlust bei Käfigtauchenden auf einer Skala von 0 bis 100 bei 75 liegt. Wir vermuten, dass die Abenteuerlust jedoch tatsächlich höher liegt und überprüfen diese Annahme mit den Daten von 30 Käfigtauchenden. (Rechtsseitige Hypothese)

Voraussetzungen & nonparametrische Alternative

WELCHE VORAUSSETZUNGEN ERFÜLLT SEIN MÜSSEN

- Die AV ist metrisch und normalverteilt

- Die Varianz bzw. Standardabweichung ist nicht bekannt und muss aus den Daten der Stichprobe geschätzt werden

NONPARAMETRISCHE ALTERNATIVE

Wilcoxon-Test für eine Stichprobe = Einstichproben-Wilcoxon-Test

Das Grundprinzip – einfach erklärt

Zunächst erkläre ich dir das Grundprinzip und zeige dir anschließend die Berechnung an einem Beispiel.

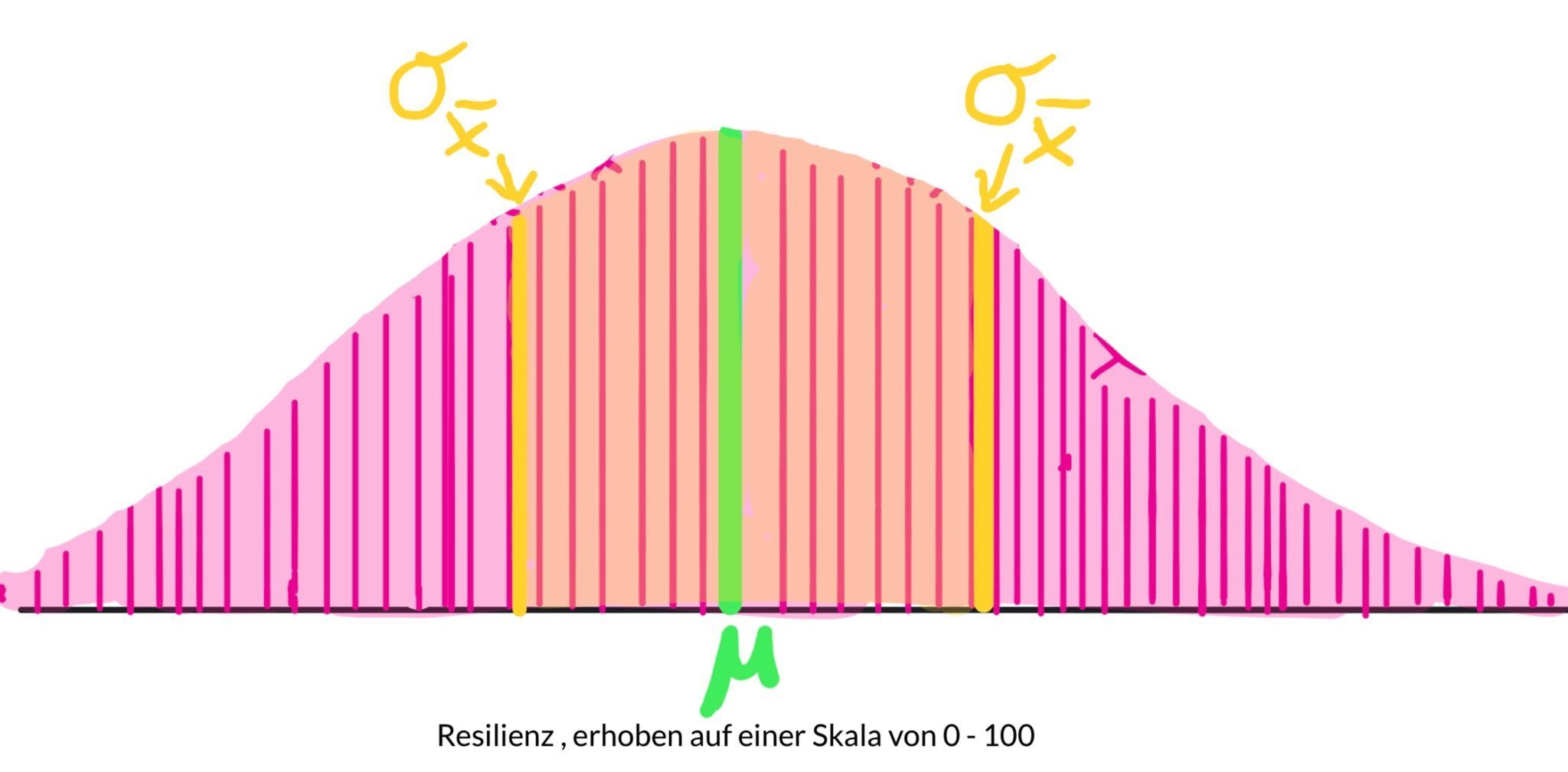

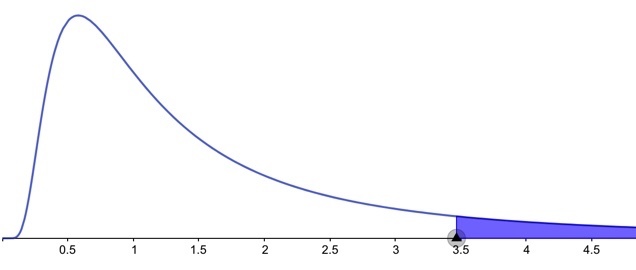

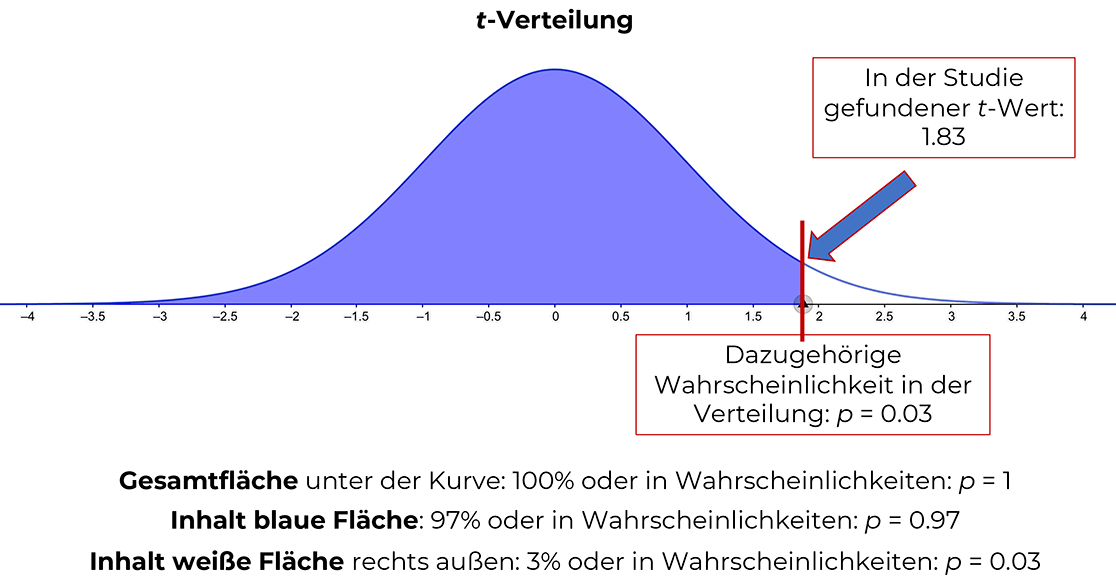

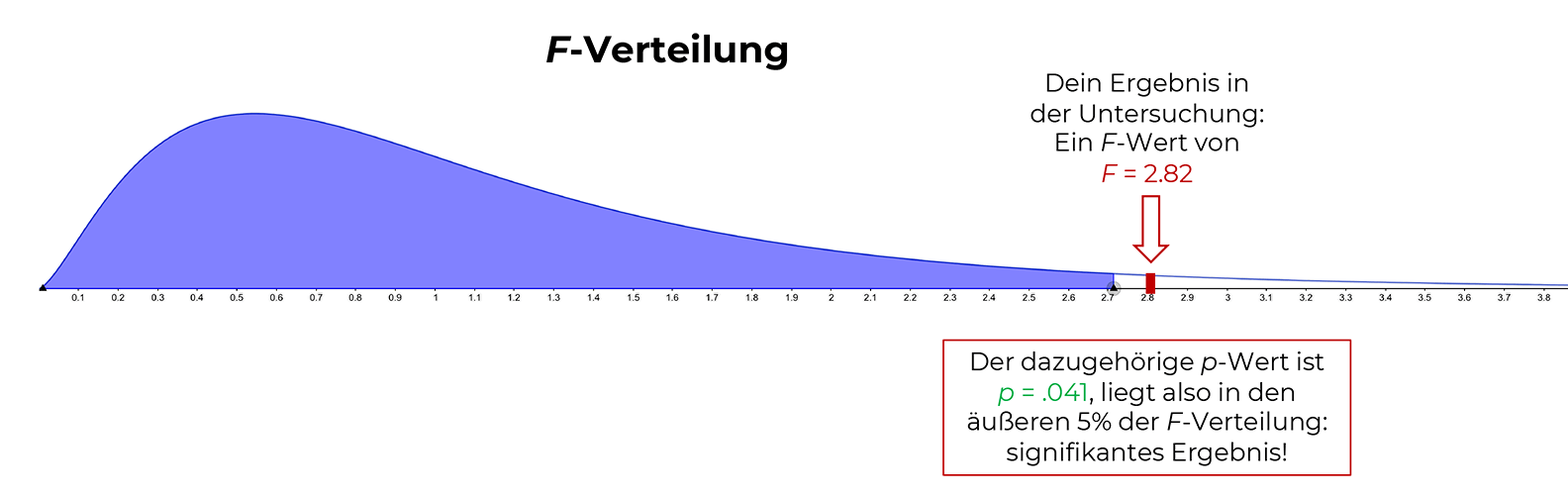

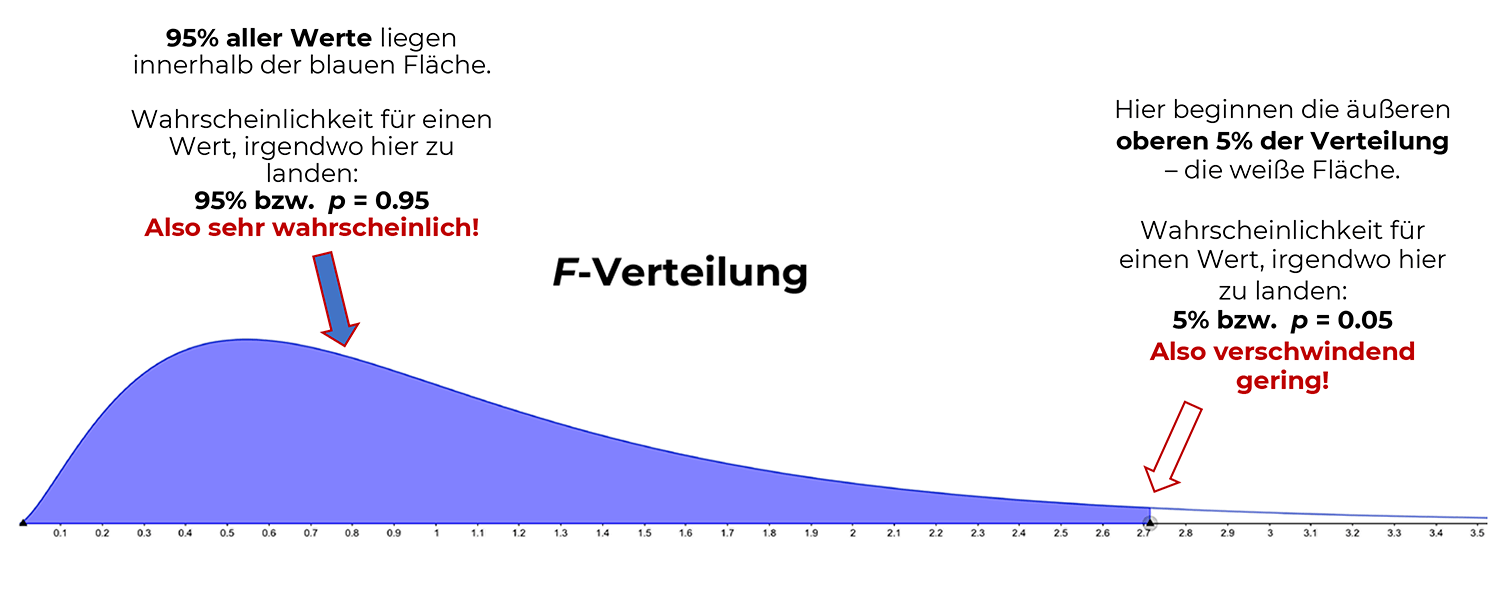

Wenn du einen t-Test durchführst, bekommst du am Ende einen sog. empirischen t-Wert heraus, der in die dazugehörige t-Verteilung hineinfällt. Diese t-Verteilung ist die Test-Verteilung für den t-Test.

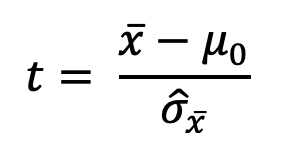

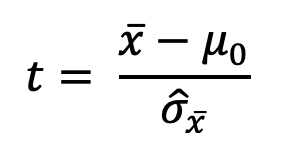

Dies ist die Formel für den Einstichproben-t-Test:

Der t-Wert (unsere "Prüfgröße") entsteht aus einem Bruch:

Im Zähler wird vom Mittelwert der Stichprobe der bereits bekannte oder angenommene Mittelwert (= Erwartungswert) abgezogen und durch den Standardfehler des Mittels im Nenner geteilt.

UND SO GEHT’S:

1. Schritt:

Du erhebst bei einer Stichprobe z. B. das Glücksgefühl nach dem Urlaub.

2. Schritt:

Daraus errechnest du den Mittelwert, die Standardabweichung (bei der Berechnung durch n – 1 teilen!) sowie den Standardfehler.

3. Schritt:

Du setzt alles in die Formel ein und erhältst den empirischen t-Wert (= der t-Wert, der aus den Daten deiner Stichprobe entsteht).

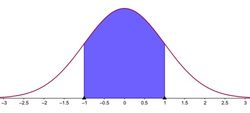

Wenn der aus den Daten der Stichprobe errechnete Mittelwert weit genug vom bekannten (oder angenommenen) Erwartungswert entfernt liegt, kommt ein empirischer t-Wert heraus, der in die äußersten Eckchen der t-Verteilung hineinfällt und somit vermutlich signifikant ist.

4. Schritt:

Um das zu überprüfen, muss der empirische t-Wert mit dem sog. kritischen t-Wert in der Tabelle der t-Verteilung verglichen werden (Näheres dazu unten).

Ist der empirische t-Wert größer (oder bei linksseitigen kleiner bzw. bei ungerichteten Hypothesen kleiner oder größer) als der kritische t-Wert, liegt ein signifikanter Unterschied vor und du verwirfst deine Nullhypothese mit deiner gewählten Irrtumswahrscheinlichkeit von z. B. 5% (Alpha = 0,05) und nimmst deine H1 an.

Wenn nicht, behältst du die Nullhypothese bei.

5. Schritt:

Wenn du ein signifikantes Ergebnis hast, berechnest du im letzten Schritt noch die dazugehörige Effektstärke Cohens d oder bei kleinen Stichproben unter N = 20 das Hedges g.

Vorgehen bei der händischen Berechnung

Überblick

Welche Hypothesen aufgestellt werden können

Bevor wir zu unserem Beispiel kommen, schauen wir uns an, welche Hypothesen grundsätzlich beim Einstichproben-t-Test gebildet werden können (x steht für den Mittelwert aus den Daten der Stichprobe):

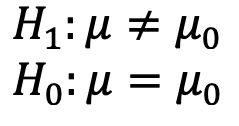

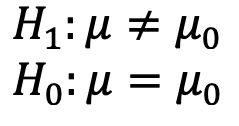

UNGERICHTETE (= ZWEISEITIGE) HYPOTHESEN

H1: x unterscheidet sich von einem bestimmten Wert

H0: Es besteht kein Unterschied zwischen x und einem bestimmten Wert

Die statistischen Hypothesen dazu:

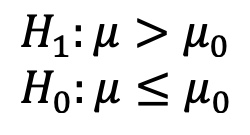

GERICHTETE (= EINSEITIGE) HYPOTHESEN

RECHTSSEITIG

H1: x ist größer als ein bestimmter Wert

H0: x ist kleiner oder gleich einem bestimmten Wert

Die statistischen Hypothesen dazu:

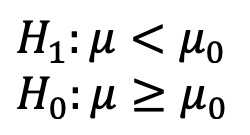

LINKSSEITIG

H1: x ist kleiner als ein bestimmter Wert

H0: x ist größer oder gleich einem bestimmten Wert

Die statistischen Hypothesen dazu:

Hypothesen für unser Beispiel

H1: Das durchschnittliche Glücksgefühl nach dem Urlaub weicht signifikant von 50 ab. (= ungerichtete Hypothese)

H0: Das durchschnittliche Glücksgefühl nach dem Urlaub ist gleich 50.

STATISTISCHE HYPOTHESEN

SIGNIFIKANZNIVEAU FESTLEGEN

Wir nehmen die übliche Irrtumswahrscheinlichkeit von 5%, d. h. ein Alpha von 0,05, da mit unserer Untersuchung keine größeren Konsequenzen verbunden sind.

VORAUSSETZUNGEN PRÜFEN

- Das Glücksgefühl ist intervallskaliert und daher metrisch

- Die Varianz bzw. Standardabweichung ist nicht bekannt

- Da wir 120 Personen in unserer Stichprobe haben, können wir gemäß des zentralen Grenzwertsatzes von Normalverteilung ausgehen

Wo wir hinwollen:

Formel für den Einstichproben-t-Test

MITTELWERT & STANDARDABWEICHUNG BERECHNEN

Die Berechnung des Mittelwertes und der Standardabweichung dürfte aus der deskriptiven Statistik bekannt sein.

Bitte beachte, dass du bei der Berechnung der Standardabweichung durch n – 1 teilen musst!

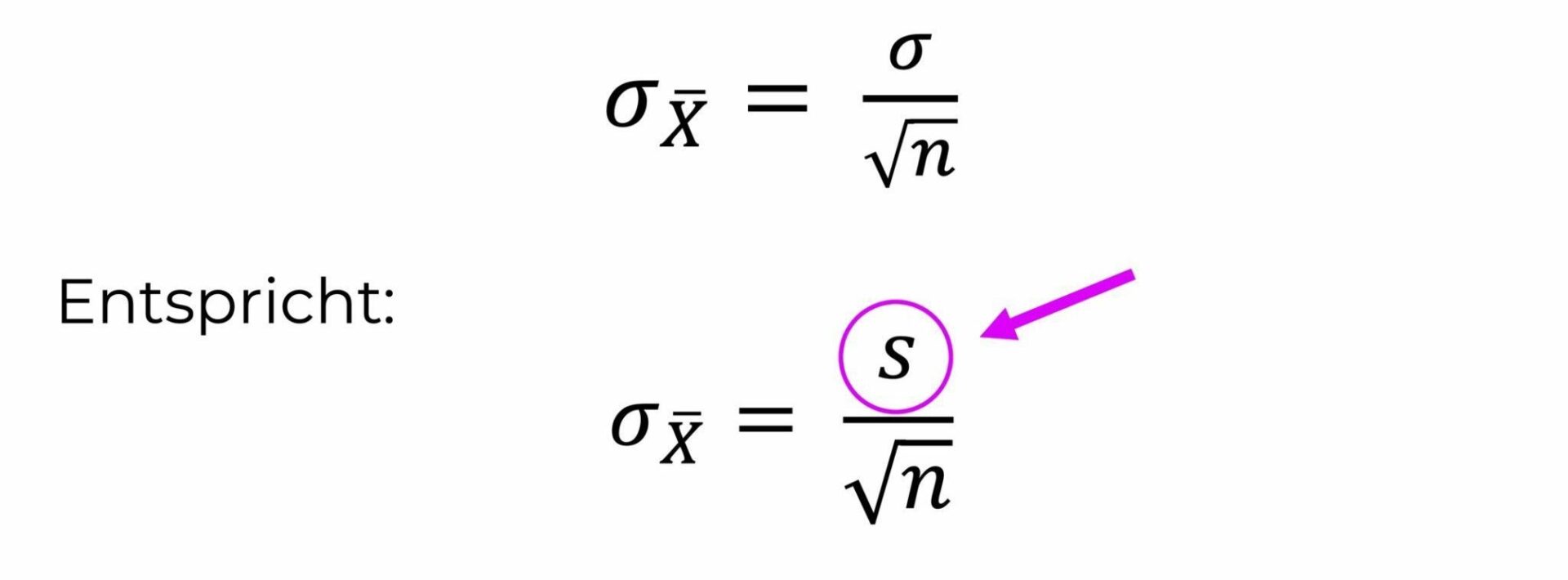

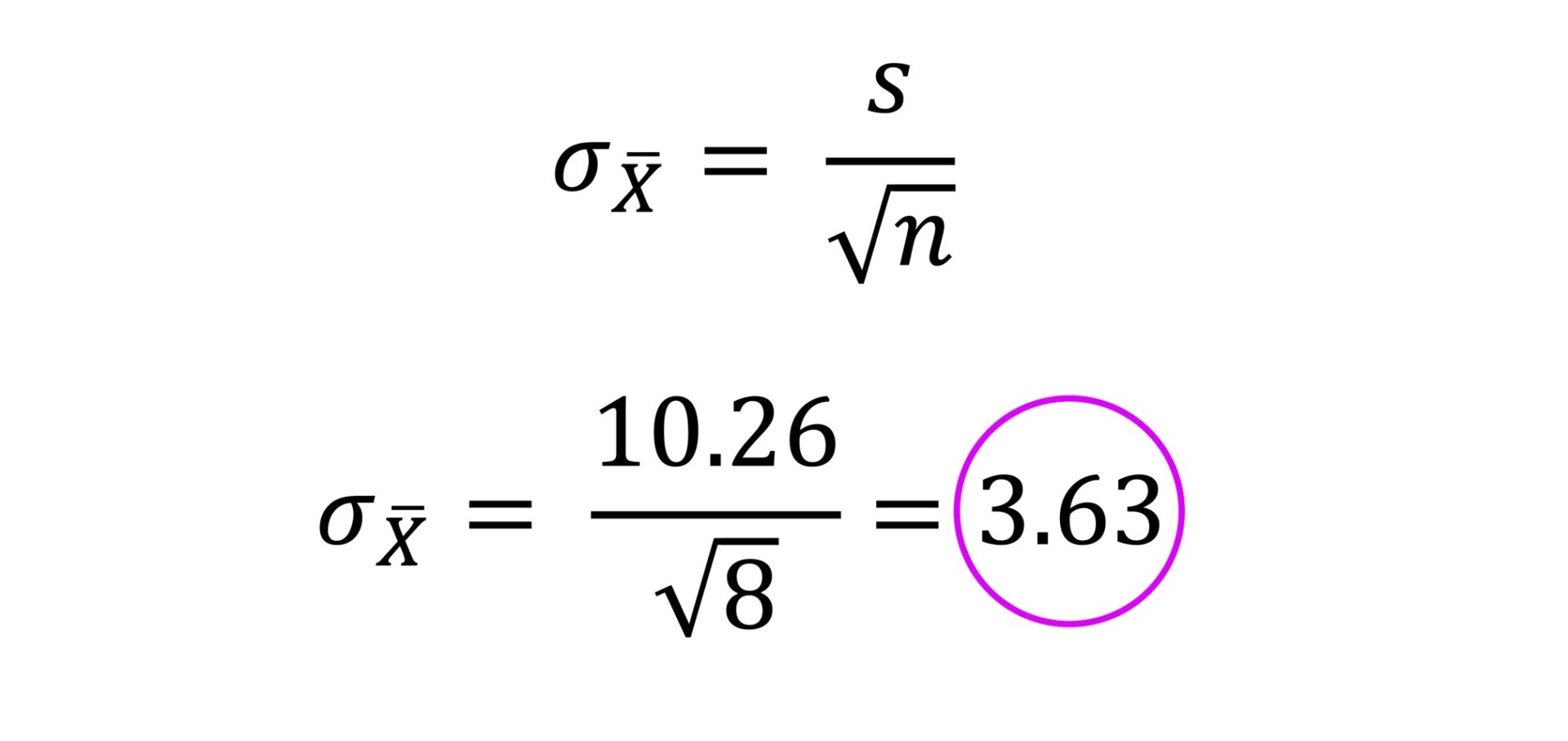

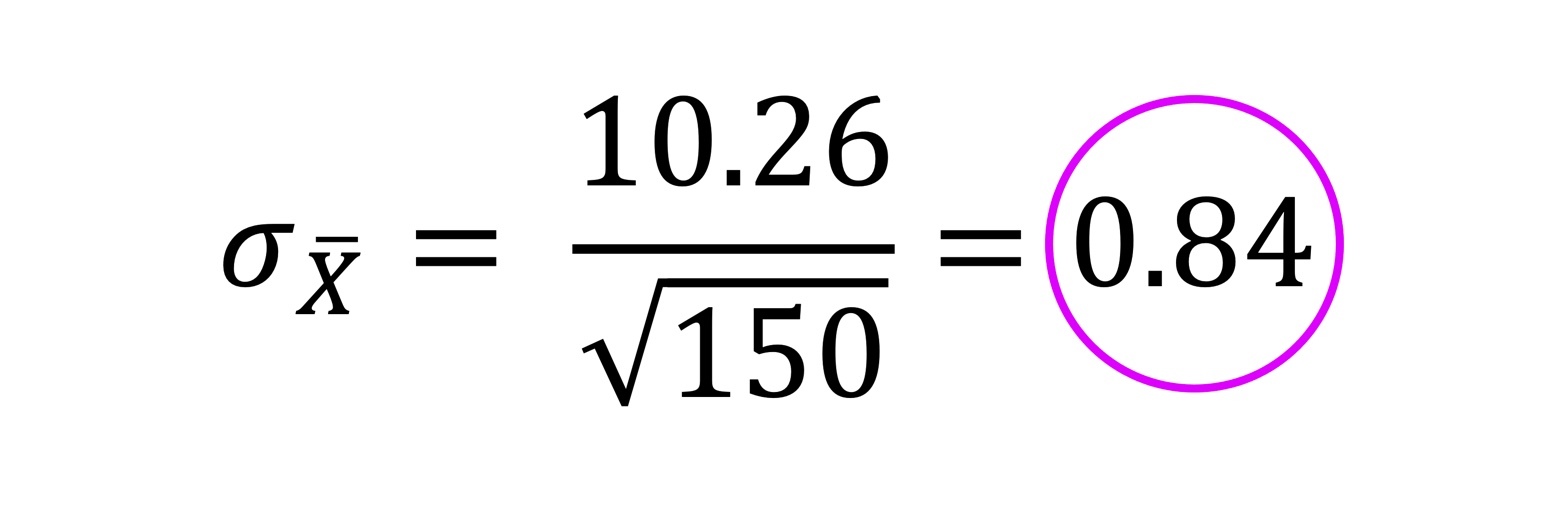

STANDARDFEHLER BERECHNEN

Angenommen, bei unserer Erhebung mit n = 120 kommen ein Mittelwert von 52 sowie eine Standardabweichung von 8 heraus. Dann können wir damit den Standardfehler berechnen:

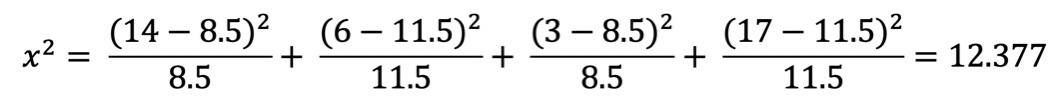

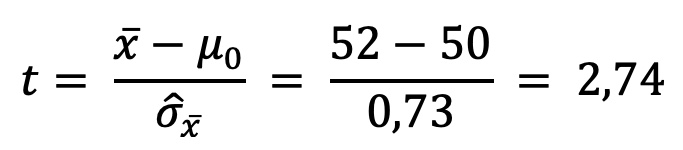

EMPIRISCHEN t-WERT BERECHNEN

PRÜFUNG AUF SIGNIFIKANZ

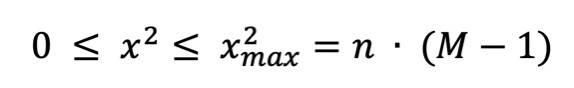

Um herauszufinden, ob unser t-Wert von 2,74 signifikant ist, benötigen wir neben dem Signifikanzniveau Alpha die sog. Freiheitsgrade, auch degrees of freedom oder df genannt, sowie die Tabelle der t-Verteilung.

FREIHEITSGRADE BESTIMMEN

Für die Freiheitsgrade ziehst du von der Stichprobengröße 1 ab:

df = N – 1 = 120 – 1 = 119

KRITISCHEN t-WERT IN DER TABELLE DER t-VERTEILUNG NACHSCHLAGEN

Jetzt schnappst du dir die Tabelle der t-Verteilung und gehst auf der linken Seite bei df nach unten, bis du die 119 Freiheitsgrade findest.

Wenn du eine Tabelle verwendest, in der die exakte Anzahl an Freiheitsgraden nicht aufgeführt ist, liest du einfach beim nächstgelegenen Wert ab – das wäre hier bei 100 Freiheitsgraden. (1. Schritt)

Sobald du die richtige Zeile gefunden hast, wanderst du in der Tabelle oben so weit nach rechts, bis du dein Alpha findest.

ACHTUNG:

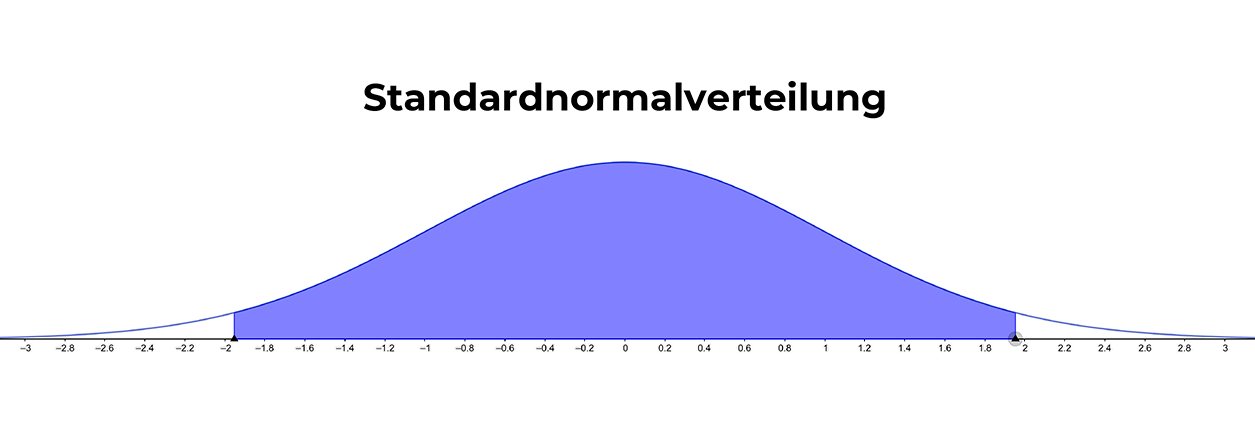

Wir haben hier eine ungerichtete, zweiseitige Hypothese!

Daher müssen wir unser Alpha durch 2 teilen und auf beide Seiten der Verteilung aufteilen.

Das bedeutet, dass unser empirischer t-Wert dann signifikant wird, wenn er in die unteren 2,5% oder die oberen 2,5% der t-Verteilung hineinfällt.

Daher suchen wir nun in der oberen Zeile der Tabelle den Wert 1 – Alpha : 2 = 1 – 0,025 = 0,975.

Das ist die Stelle in der t-Verteilung, an der sich von unten weg 97,5% aller Werte angesammelt haben (2. Schritt).

Im 3. Schritt suchst du dir den Schnittpunkt dieser beiden Werte und liest den kritischen t-Wert ab. Dieser zeigt an, wo die oberen 2,5% aller Werte in der t-Verteilung losgehen.

Hier sind die einzelnen Schritte:

Bei einem Alpha von 0,05 und 100 Freiheitsgraden ist der kritische Wert t = 1,984. Das bedeutet, dass ab diesem Wert die oberen 2,5% aller Werte in der t-Verteilung beginnen.

Weil die t-Verteilung symmetrisch ist, kannst du einfach nur ein Minus davor setzen und hast somit auch gleich den Wert am linken Ende der Verteilung, an dem die unteren 2,5% enden.

Du benötigst also für ein signifikantes Ergebnis entweder einen empirischen t-Wert, der größer als 1,984 oder kleiner als -1,984 ist.

Übrigens:

Es gibt verschiedene t-Tabellen, die jeweils unterschiedlich aufgebaut sind. Daher ist das nur eine grobe Beschreibung der Vorgehensweise beim Ablesen des kritischen t-Werts (= t mit einem tiefergestellten „krit"), die sich von der an deiner Hochschule verwendeten Tabelle unterscheiden kann.

WO ABLESEN BEI EINER RECHTS- ODER LINKSSEITIGEN HYPOTHESE?

RECHTSSEITIG

Hätten wir auf dem gleichen Signifikanzniveau von 5% rechtsseitig getestet, würden wir in der oberen Zeile bei 0,95 (= 1 – 0,05) bis zum Schnittpunkt mit den 100 Freiheitsgraden hinuntergehen.

Bedeutet: Du bräuchtest hier für ein signifikantes Ergebnis einen empirischen t-Wert größer 1,66.

LINKSSEITIG

Bei einer linksseitigen Hypothese würden wir zunächst wie bei der rechtsseitigen Hypothese beschrieben vorgehen und dann aufgrund der Symmetrie der Verteilung einfach ein Minus vor den gefundenen Wert von 1,66 setzen.

In diesem Fall müsste der empirische t-Wert kleiner als -1,66 sein, um signifikant zu werden.

EMPIRISCHEN t-WERT MIT DEM KRITISCHEN t-WERT VERGLEICHEN

Unser empirischer t-Wert von 2,74 ist größer als 1,984. Daher verwerfen wir die Nullhypothese und nehmen unsere Alternativhypothese mit einer 5%-igen Irrtumswahrscheinlichkeit an.

Wir können nun verkünden:

Das durchschnittliche Glücksgefühl nach dem Urlaub weicht signifikant von 50 ab.

WICHTIGER HINWEIS FÜR HINTER DIE LÖFFELCHEN:

Bei der Ergebnis-Interpretation von gerichteten Hypothesen bitte immer darauf achten, ob die Ergebnisse auch wirklich in deine postulierte Richtung gehen!

Denn du könntest ein signifikantes Ergebnis haben, das jedoch genau in die Gegenrichtung deiner Hypothese geht – und dann ist es bezogen auf deine „Ursprungs-Hypothese" NICHT signifikant.

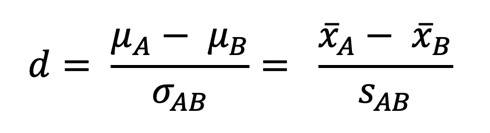

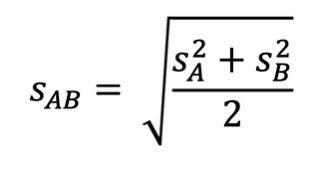

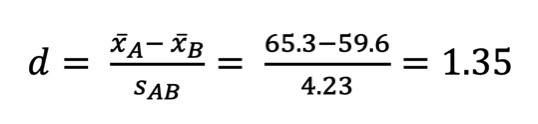

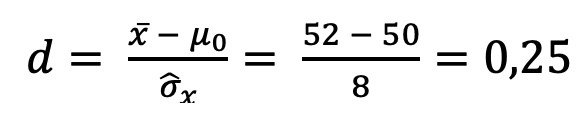

EFFEKTSTÄRKE

Da wir ein signifikantes Ergebnis haben, berechnen wir nun die Effektstärke Cohens d.

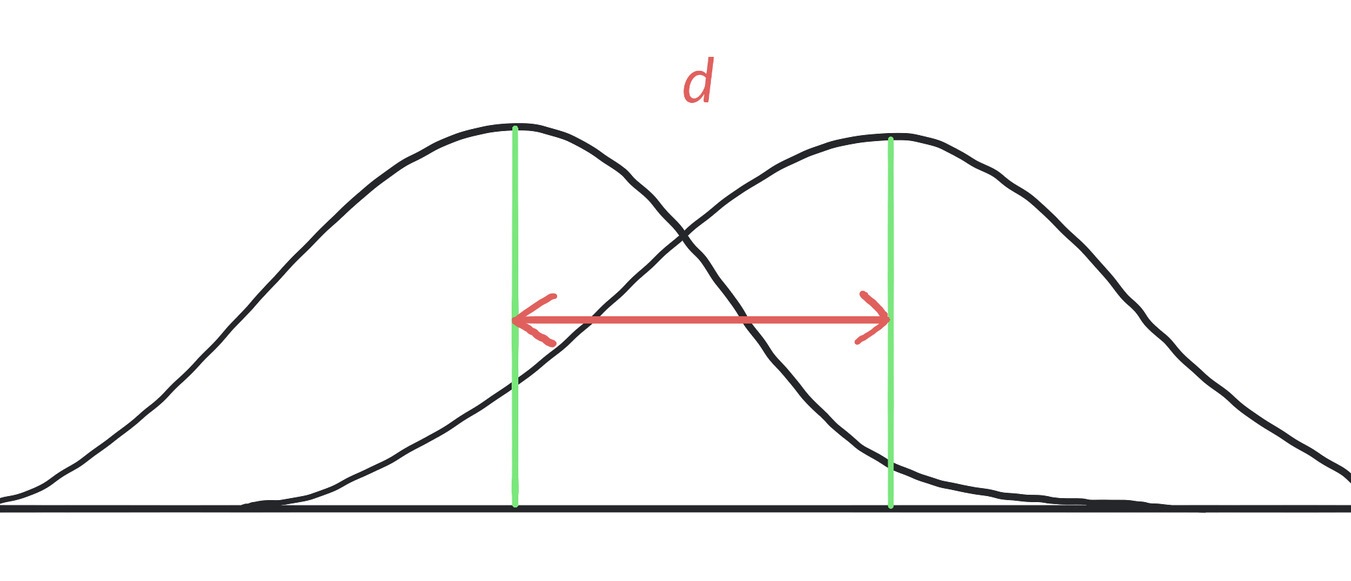

Cohens d sagt aus, wie groß der Unterschied zwischen den beiden Mittelwerten ist und ob es sich um einen praktisch relevanten Effekt handelt.

Hier ist die Formel dazu:

Und was bedeutet das nun?

Sofern du aus der Forschungsliteratur keinen anderen Anhaltspunkt hast, kannst du dich bei der Interpretation nach den Konventionen nach Cohen (1988) richten:

Kleiner Effekt: |0,2|

Mittlerer Effekt: |0,5|

Starker Effekt: |0,8|

Wohlgemerkt alles im Betrag!

Bedeutet: Egal, ob das Ergebnis z. B. -0,3 oder +0,3 beträgt – der Effekt ist gleich groß.

Unser Cohens d von 0,25 ist ein kleiner Effekt.

Ergebnis korrekt berichten

Du kannst das Ergebnis entweder mit Angabe von Mittelwerten (= M) und Standardabweichungen (= SD) oder ohne berichten, denn diese Angaben werden nicht immer gefordert.

Halte dich daher bitte im Zweifelsfall an das, was an deiner Hochschule Usus ist!

Hier sind beide Varianten:

Das Glücksgefühl nach dem Urlaub (M = 52, SD = 8) ist signifikant höher als 50, t(119) = 2,74, d = 0,25.

Das Glücksgefühl nach dem Urlaub ist signifikant höher als 50, t(119) = 2,74, d = 0,25.

Interpretation für Tante Erna

Wir haben untersucht, ob das Glücksgefühl nach dem Urlaub signifikant von einem „durchschnittlichen" Glücksgefühl von 50 abweicht, gemessen auf einer Skala von 0 bis 100.

Es hat sich gezeigt, dass das Glücksgefühl nach dem Urlaub signifikant höher ist als angenommen, wobei es sich um einen eher kleinen und damit praktisch wenig relevanten Unterschied handelt.

Kurz & knackig zusammengefasst

Der Einstichproben-t-Test ist das Verfahren der Wahl, wenn es um den Unterschied zwischen einem angenommenen oder bekannten Mittelwert und dem Mittelwert aus einer Stichprobe geht.

Dies erkennst du meist an Angaben wie: „Es ist bekannt, dass der Erwartungswert von x bei y liegt."

Die Varianz bzw. Standardabweichung sind unbekannt.

Es können gerichtete und ungerichtete Hypothesen getestet werden.

Falls die Voraussetzungen für den Einstichproben-t-Test verletzt sind, verwendest du als nonparametrische Alternative den Wilcoxon-Test für eine Stichprobe.

UND DAS WAR’S – GESCHAFFT! NA BITTE, GEHT DOCH!

Das war dein rundum sorglos Paket zum Einstichproben-t-Test.

Damit hast du dir jetzt redlich ein Limettentörtchen verdient!

Jetzt wünsche ich dir noch einen knackenden Tag, gutes Umsetzen und natürlich weiterhin:

HAPPY LEARNING!

QUELLEN (Als Amazon-Partnerin verdiene ich an qualifizierten Verkäufen):

Bortz, J., & Schuster, C. (2017). Statistik für Human- und Sozialwissenschaftler. Springer.

Bühner, M., & Ziegler, M. (2017). Statistik für Psychologen und Sozialwissenschaftler. Pearson.

Cohen, J. (1988). Statistical power analysis for the behavioral sciences (2nd ed). Hillsdale, N.J: L. Erlbaum Associates.

Field, A. (2018). Discovering Statistics using IBM SPSS Statistics. SAGE.

! Das ist also eine rein theoretische Vorstellung. In der Praxis nimmt man nur

! Das ist also eine rein theoretische Vorstellung. In der Praxis nimmt man nur